Om du känner dig översköljd av artificiell intelligens är du inte ensam. Utvecklare kan inte sluta prata om möjligheterna med generativ AI (Gen AI) för att förändra hur de kodar. Vd:arna kan inte heller sluta prata om det: AI-relaterade samtal på telefonkonferenser har ”gått i taket” på sistone. Det finns så mycket AI att vi till och med har börjat träna de stora språkmodellerna (LLM) bakom Gen AI-applikationer med utdata från dessa applikationer. (Detta kommer inte att sluta väl.)

Men mitt i all denna oändliga hype och förhoppning kring AI lyckades ett företag nyligen prata i över två timmar under en global keynote utan att nämna AI en enda gång, trots att AI:s inverkan var allestädes närvarande i de produkter som visades upp. Det företaget är Apple, och dess ordknapphet är en lektion för alla i hur man använder AI på rätt sätt.

Snacka går ju

Även om AI-snacket har gått på högvarv är AI-hajp inte precis något nytt, vilket Mark Raskino, analytiker på Gartner, påpekar. Pratet om AI ökade kraftigt i början av 1980-talet och har inte avtagit sedan dess. Det som är annorlunda nu är dock hur utbrett AI har blivit, både inom och utanför tekniska kretsar. För vissa är saker som Chat GPT ett ”fordon för viral hajp” – ett fordon som fortsätter att öka i hastighet.

En sådan hastighet kommer med konsekvenser. Till exempel behöver varje LLM data, och rika datakällor som Internet Archive, Stack Overflow, Reddit med flera har sett massiva trafikökningar, vilket har lett till krascher för Internet Archive och rättsliga blockader från Reddit och andra. Samtidigt kämpar vissa för att förhindra påstådda upphovsrättsintrång i de träningsdata som används för att mata applikationer som Github Copilot. Det hela är lite rörigt.

James Penny, investeringschef på TAM Asset Management, menar att ”företag som ens nämner ordet AI i sina resultat får se sina aktiekurser stiga, och det luktar väldigt mycket som dot-com-eran”. Även om det verkar lite fånigt med tanke på hur oprövade saker som Gen AI fortfarande är, finns det bevis för att AI har drivit uppgången på aktiemarknaden utan att faktiskt göra mycket för att driva en motsvarande uppgång i företagens resultat.

Dot-com-eran, sannerligen.

Samtidigt fortsätter ett företag att göra stora investeringar i AI utan att göra en stor sak av AI. Det företaget är Apple, och det pekar på en mer ansvarsfull och produktiv användning av AI än vad de flesta företag har lyckats med.

Bakom kulisserna

AI är inte nytt för Apple. Företaget har gjort AI till en integrerad del av sina produkter med Siri och andra mindre synliga (eller hörbara) sätt. Det är inte förvånande att Apple har anställt specialister inom AI under en lång tid, och dessa anställningar har blivit mer märkbara på senare tid. Företaget har en karriärsida som är dedikerad till AI, med rubriken ”Maskininlärning och AI: Arbetet är innovativt. Upplevelsen är magisk.”

På den sidan berättar Apple hemligheten bakom hur de använder AI: ”De som arbetar här med maskininlärning och AI bygger fantastiska upplevelser i varje Apple-produkt, så att miljoner människor kan göra vad de aldrig kunnat föreställa sig.” Deras fokus ligger med andra ord på hur kunderna upplever AI, inte på själva AI:n. Detta har länge varit Apples strategi: att göra tekniken till en integrerad del av kundens upplevelse utan att göra tekniken till fokus för den upplevelsen. Tekniken är tänkt att vara i princip osynlig. Om du märker det har Apple misslyckats.

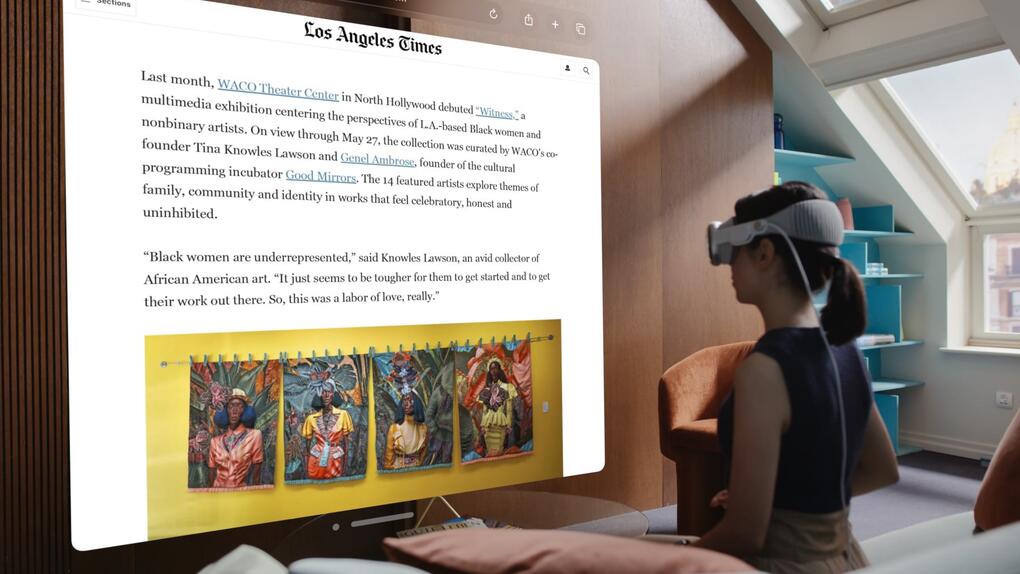

På scenen vid sin årliga Worldwide Developers Conference tenderade Apple att referera till AI som magi. Ordet användes 13 gånger. (Apple överanvänder ordet magi på samma sätt som de flesta företag överanvänder termen AI). På tal om den nya Apple Vision Pro sa Apple-chefen Alan Dye: ”Det är enastående och det känns som magi.” Han behövde inte gå in på detaljerna kring AI och annan teknik som bidrar till denna magi. Poängen är upplevelsen, inte ingredienserna.

Det här är en bra lärdom för alla företag.

För det första, även om Gen AI är den aktuella ”inne”-tekniken är det inte alltid rätt tillvägagångssätt. Mathew Lodge på Diffblue rekommenderade nyligen att förstärkt inlärning trumfar Gen AI för vissa användningsfall. Långt innan Gen AI blev det stora samtalsämnet var det också så att regressionsanalys eller andra metoder skulle vara företagets första stopp innan man hoppade på maskininlärningsbussen.

Mer nyligen hade jag ett samtal med en branschvän som betonade: ”Du kan använda en LLM för många saker, men om din output är strukturerad data snarare än ostrukturerad, kan det vara ett mycket ineffektivt sätt att göra det på.” Det är en intressant poäng eftersom vissa av de Gen AI-tjänster som molnleverantörerna lanserar redan har gjorts tidigare med hjälp av dedikerade modeller, som visar sig vara mycket effektivare än Gen AI. Som han förklarar är utvecklare förtjusta i Gen AI eftersom det är probabilistiskt till sin natur; det försöker inte hitta det enda sanna svaret, utan snarare ett rimligt svar givet mönster i träningsdata. Det kan vara bra, men det är ”som att söka utan index. Det skalar inte bra.”

Det betyder inte att Gen AI är dåligt. Det är bara inte bra eller bäst för en rad olika användningsfall. (Och även när det är en bra metod kräver den fortfarande mycket resurser). För vissa användningsområden fungerar gammaldags inferens bäst. Inferens är ett sätt att träna AI att se mönster i data och sedan jämföra inkommande nya data mot dessa mönster. Gen AI, återigen, handlar om att skapa saker som ser ut som data i LLM, vilket resulterar i nyskapade data som är rimliga men inte nödvändigtvis korrekta. Båda är intressanta, men ingen av dem är alltid rätt verktyg.

För det andra, oavsett vilken strategi för AI ett företag väljer (och verkligheten är att de flesta företag kommer att vilja anamma en rad olika strategier eftersom de har en rad olika användningsfall), bör AI aldrig vara poängen. AI är ett medel, inte ett mål. Som Apple visade är det mycket möjligt att sälja en AI-baserad vision utan att göra AI till poängen med pitchen. Ingen bryr sig egentligen om hur häftigt AI är. De bryr sig om den resulterande upplevelsen.

Så sälj AI-upplevelsen, inte AI:n.

Matt Asay ansvarar för utvecklarrelationer på MongoDB och är kolumnist för vår amerikanska systersajt Infoworld. De åsikter som uttrycks här är Matts egna och återspeglar inte hans arbetsgivares åsikter.